Herman Ohlsson

Analytiker med fokus på halvledarsektorn, Brock Milton Capital AB

Tänk på att:

Historisk avkastning är ingen garanti för framtida avkastning. De pengar som placeras i fonder kan både öka och minska i värde och det är inte säkert att du får tillbaka hela det insatta kapitalet.

Blogg & Media

Blogg | 16 okt 2024

Då var det dags för del två av summeringen från vår analysresa till Silicon Valley. I denna del kommer jag att fokusera mer på halvledarbolagen och vilka trender vi ser där, samt det senaste inom AI. Under resan träffade vi närmare 20 bolag däribland Nvidia, Broadcom, Cadence, Synopsys och Applied Materials.

I del ett av summeringen från vår analysresa till San Fransisco går Henrik Milton igenom Teslas människoliknande robotar, Waymo’s självkörande taxibilar och Nvidias teknik för självkörande bilar.

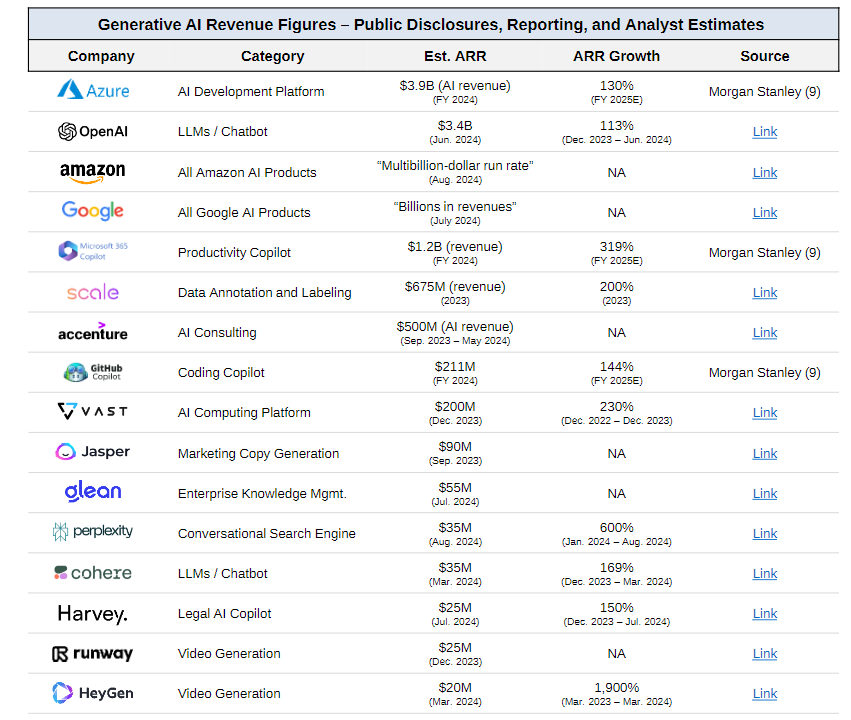

En första intressant spaning är att cirka 70% av alla frågor i samtliga möten under veckan handlade om AI på ett eller annat sätt. Antingen om hur bolagen gynnas av detta, vilka produkter man lanserat, hur köpbenägna kunderna är eller vilken avkastning bolagen får på dessa enorma investeringar i AI. Gällande det sistnämnda noterade vi ett tydligt skifte i flera av mötena. Flera investerare börjar ifrågasätta de investeringar som gjorts i AI eftersom monetäriseringen av dessa inte är tillräckligt stor i dagsläget. Avkastningen på de tusentals grafikkort man köpt från Nvidia är helt enkelt begränsad än så länge. Å andra sidan befinner sig fler bolag i ett relativt tidigt stadie vad gäller utvecklingen av AI och flera av de bolag vi träffade förväntar sig inte heller något märkbart bidrag från AI nästa år. Infrastrukturen har än så länge byggts ut, och fortsätter att göras så, vilket framför allt gynnat Nvidia och värdekedjan för halvledarbolagen i ett första steg. I ett andra steg har bolag som driver datacenter, så kallade hyperscalers (Microsoft, Google, Meta och Amazon), gynnats kraftigt då de hyr ut tillgång till Nvidias grafikkort för att träna AI-modeller. I det tredje steget när det kommer till mjukvarubolag med slutkundskontakt, är effekten desto blygsammare än så länge. Här befinner man sig i ett mer experimenterande stadie där bolagen utforskar vilka produkter man kan ta betalt för och framför allt hur en sådan modell kan se ut.

Bild: Herman (t.v) och Henrik (t.h) utanför Nvidias kontor i San Jose.

Bild: Herman (t.v) och Henrik (t.h) utanför Nvidias kontor i San Jose.

Vi tror det kommer ta längre tid än vad många tror innan fler bolag ser en tydlig väg framåt för att kunna ta betalt för sina AI-tjänster. Som vanligt tenderar ny teknik att överskattas kortsiktigt men underskattas långsiktigt. Vi tror dessutom att de mjukvarubolag som kommer gynnas främst framåt är ”plattforms-bolag” så som Microsoft, Google, Adobe och SerivceNow, som alla är innehav i BMC Global Select.

Detta då de har en enorm skalbarhet via sina miljontals användare, och kan implementera AI i sina produktportföljer, samt att bolagen har de ekonomiska resurser som krävs för att investera i AI. Dessa bolag har också visat sig vara bland de bolag, bortsett från Nvidia, som hittills lyckas monetärisera på AI i störst utsträckning.

Nedan bild visar vilka av cloud- och mjukvarubolagen som tjänar mest pengar på AI i dagsläget. ChatGPT som ägs av OpenAI är bland de bolag som fortsatt är med i toppen på 3,4 miljarder dollar i årlig omsättning. Bortsett från dem och så kallade hyperscalers (Microsoft, Meta, Amazon, Google), är det få bolag med större intjäning. Detta förklarar också varför bolag, som också ingår i ”Magnificent 7”, har gått så bra på sistone. Ingen eld utan rök helt enkelt.

Bildkälla: Sapphire July 2024 market memo

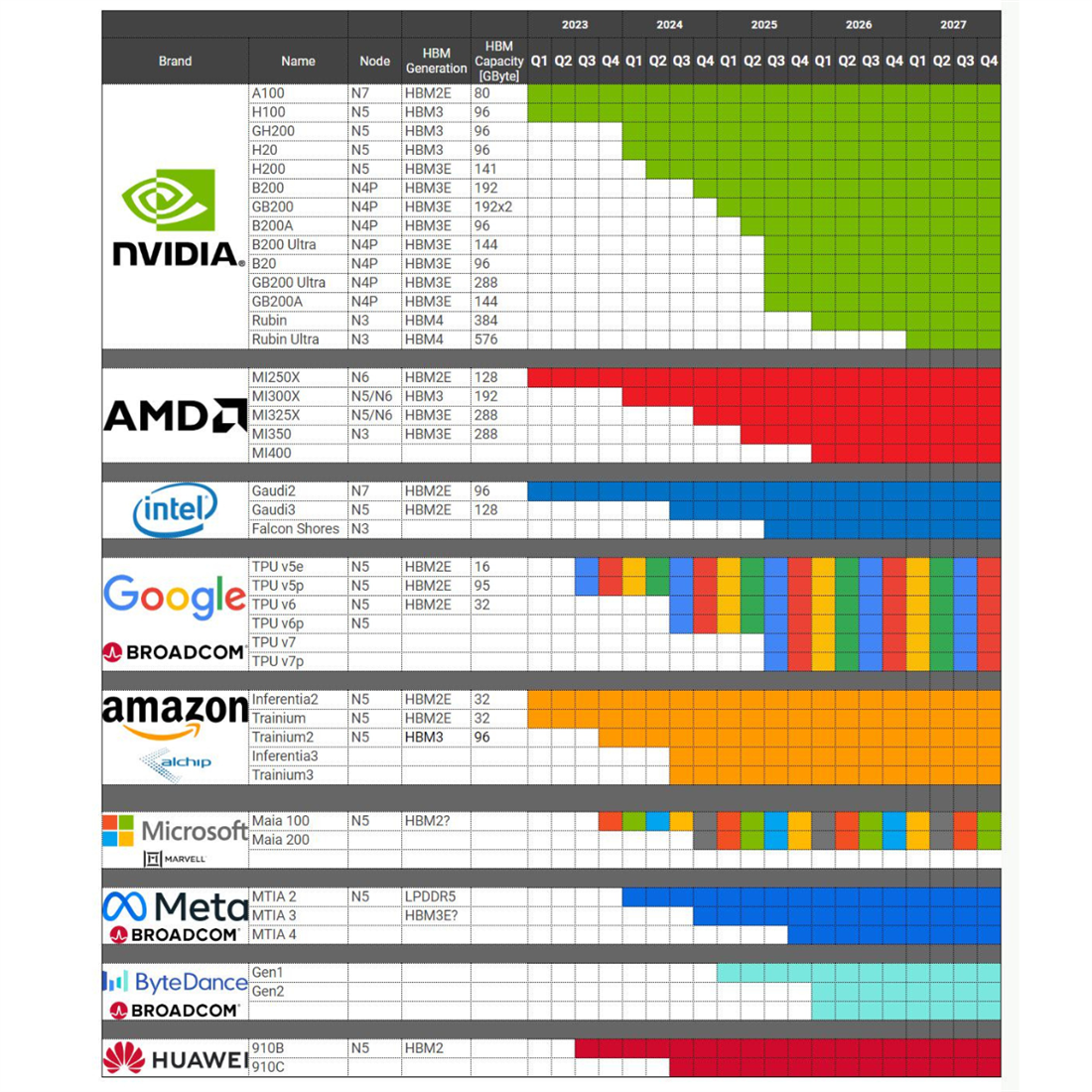

Hyperscalers investerar kraftigt i utveckling av egna chip

En annan trend som vi märkte har accelererat ytterligare sedan vår resa förra året och som drivs av den starka efterfrågan för AI, är utvecklingen av egna chip hos hyperscalers. Idag köper dessa bolag majoriteten av sina AI-chip från Nvidia eftersom bolaget har de bästa och mest mångsidiga chipen som går att använda för alla typer av AI-modeller. Problemet för hyperscalers är dock att chipen från Nvidia dels är väldigt dyra, dels svåra att få tag på. Priset för Nvidia senaste AI-chip, kallat Blackwell, uppgår till närmare 400 000 kr per chip. När man tränar en AI-modell är det inte ovanligt att det krävs 20 000 chip eller fler vilket innebär en initial investering på cirka åtta miljarder kronor. Detta är exklusive kostnaden för den el som går åt för att löpande köra dessa chip i ett datacenter. Med tanke på att varje chip drar 1000W[1] och att man använder 20 000 st uppgår den årliga förbrukningen till 175GWh. Med ett uppskattat pris på $0,17/KWh[2] så uppgår den årliga kostnaden enbart för elen till dryga 300 miljoner kronor.

Detta har resulterat i att hyperscalers har börjat investera i att designa egna mer energieffektiva AI-chip som är optimerade efter sin egen mjukvara, vilket göra att man sänker kostnaden samt kontrollerar tillgången till chipen. Precis vad Apple har gjort sedan länge, och bolaget har ett av Silicon Valleys främsta designteam (kallas Apple Silicon) inom halvledare, som tar fram chip som är optimerade för deras mjukvara. Detta gör att man kan differentiera sig vilket skapar en stark konkurrenskraft. Ett annat exempel är Tesla som i princip designar alla sina chip själva, både för sina elbilar och för sina projekt inom AI. Tesla har exempelvis ett egenutvecklat AI-chip (Dojo), som utvecklats för att träna deras AI-mjukvara för självkörande bilar och sin ”mänskliga” robot kallad Optimus.

Bild: Alla typer av datacenter chip som designas av företag utöver Nvidia, AMD och Intel. Källa: Fubon

Bild: Alla typer av datacenter chip som designas av företag utöver Nvidia, AMD och Intel. Källa: Fubon

Intressant är också att Vd:n på Broadcom under vårt möte berättade att han ändrat sin syn och tror att hyperscalers egna chip i framtiden kommer kunna bli väldigt konkurrenskraftiga. Detta givet den acceleration de sett av hyperscalers investeringar i egna chip och förbättrad prestandan för det samma. Broadcom designar framför allt chip till teleoperatörer och nätverksutrustning men har också en del där man hjälper bolag att designa AI-chip. Inom denna del har man tre stora kunder varav Google och Meta är de två största. I år förväntas man generera cirka 12 miljarder USD från AI-chip och nätverksutrustning. Detta är mindre än Nvidias dryga 110 miljarder USD men mer än AMDs cirka 5 miljarder USD. Broadcom är således näst störst på AI-chip efter Nvidia.

Bild: Henrik och Herman tillsammans med Broadcoms VD Hook Tan.

Samma bild som Broadcoms VD delade fick vi från mötena med våra två innehav, Cadence och Synopsys, som också ser en stark tillväxt från just hyperscalers. Båda bolagen kommer gynnas kraftigt när fler företag börjar designa sina egna chip då de säljer den kritiska mjukvaran som används vid design av dessa. Cadence sa bland annat att hyperscalers har stort utrymme att växa som kunder framåt. På samma tema berättade Synopsys att hyperscalers har vuxit snabbare än halvledarbolagen och står nu för 50% av omsättningen, upp från cirka 40% för bara några år sedan. För att kunna ta fram ännu kraftfullare och konkurrenskraftigare chip kommer hyperscalers behöva investera i mer mjukvara och anställa fler designingenjörer framåt. Detta gjorde att vi kom hem med en väldigt positiv syn på bolagen som vi tror kommer kunna växa kraftigt kommande år. Vi har därför ökat vårt innehav i båda bolagen efter resan då värderingarna har kommit ner kraftigt sedan i somras, trots att bolagen går på högvarv.

Energikonsumtionen behöver minska för bredare adoption av AI

Under vår resa träffade vi även halvledarbolaget Applied Material som tillverkar maskiner för halvledartillverkning. Ett imponerande bolag som gynnas av att komplexiteten ökar vid tillverkning av chip, framför allt AI-chip.

Den starkaste trenden för dem just nu är att förbättra chipen så att de blir mer energieffektiva. Detta är avgörande för att AI ska kunna nå en bredare publik och användas av fler bolag. Ett AI-chip kräver exempelvis 10x mer el jämfört med ett vanligt chip i ett datacenter.

Detta innebär i sin tur att även en sökning på ChatGPT drar 10x mer el än en vanlig Google sökning [3]. Även om ChatGPTs svar är av bättre kvalitet än Googles så krävs det att energieffektiviteten ökar över tid för att göra det mer ekonomiskt hållbart. Nvidia har således starka incitament att samarbeta med Applied Materials så att mer energieffektiva chip kan produceras. Applied Materials utvecklar nu maskiner för en ny typ av arkitektur för chip, kallat Gate All Around (GAA), som gör chipen upp till 30% mer energieffektiva. Lansering av dessa förväntas ske under nästa år.

Bild: Herman och Henrik tillsammans med IR på Applied Materials.

Efter en väldigt intensiv och intressant analysresa till San Francisco kom vi hem med mer kunskap om de senaste trenderna inom mjukvara och halvledare samt en positiv syn på halvledarsektorn som nu börjar vända samtidigt som AI fortsätter vara det heta ämnet. Vi fick också en djupare förståelse för de långsiktiga trender som vi beskrivit i detta blogginlägg, som vi tror kommer gynna flera av våra bolag framåt och bidra med positiv avkastning till våra andelsägare.

[1] https://www.trendforce.com/presscenter/news/20240730-12232.html

[2] https://www.bls.gov/regions/midwest/data/averageenergyprices_selectedareas_table.htm

[3] Synopsys CMD 2024

Blogg | 1 apr 2025

Blogg | 18 mar 2025

Blogg | 7 mar 2025

Den här webbplatsen använder cookiesför statistik och användarupplevelse.

Brock Milton Capital. använder cookies för att förbättra din användarupplevelse, för att ge underlag till förbättring och vidareutveckling av hemsidan samt för att kunna rikta mer relevanta erbjudanden till dig.

Läs gärna vår Integritetspolicy . Om du samtycker till vår användning, välj Tillåt alla. Om du vill ändra ditt val i efterhand hittar du den möjligheten i botten på sidan.